Di tengah pesatnya perkembangan kecerdasan buatan (AI), muncul sebuah tantangan baru: bagaimana aplikasi AI yang berbeda dapat saling berkomunikasi dan berbagi konteks dengan Large Language Models (LLM) secara efisien dan terstandarisasi?

Jawabannya hadir dalam bentuk Model Context Protocol (MCP), sebuah protokol terbuka yang merevolusi cara aplikasi menyediakan konteks ke LLM.

Untuk mempermudah implementasinya, hadirlah FastMCP, sebuah Software Development Kit (SDK) Python yang mempercepat dan menyederhanakan pembuatan klien dan server MCP.

Bayangkan MCP seperti port USB-C untuk aplikasi AI Anda. Sebagaimana USB-C menyediakan cara terstandarisasi untuk menghubungkan perangkat Anda ke berbagai periferal, MCP menyediakan cara terstandarisasi untuk menghubungkan model AI ke berbagai sumber data dan alat.

Apa itu Model Context Protocol (MCP)?

Model Context Protocol (MCP) adalah sebuah standar terbuka yang dirancang untuk menjadi jembatan komunikasi antara aplikasi AI (klien) dengan berbagai sumber data dan fungsionalitas eksternal (server).

Protokol ini memungkinkan LLM untuk secara dinamis mengakses informasi yang relevan dan menggunakan alat-alat di luar pengetahuannya yang terbatas pada data pelatihan.

Dengan MCP, pengembang tidak perlu lagi membuat integrasi khusus yang rumit untuk setiap aplikasi dan sumber data baru.

Cukup dengan mengikuti standar MCP, sebuah aplikasi dapat dengan mudah "berbicara" dengan server mana pun yang juga menerapkan protokol yang sama.

Mengapa MCP Penting?

Kehadiran MCP membawa sejumlah manfaat signifikan dalam ekosistem pengembangan AI:

- Interoperabilitas: MCP menciptakan bahasa yang sama bagi berbagai aplikasi dan alat AI, memungkinkan mereka untuk saling terhubung dan bekerja sama dengan mulus. Hal ini mendorong ekosistem yang lebih kolaboratif dan inovatif.

- Skalabilitas: Dengan pendekatan terstandarisasi, aplikasi yang didukung MCP dapat dengan mudah diskalakan untuk terhubung dengan berbagai sumber data baru tanpa perlu rekayasa ulang yang kompleks.

- Fleksibilitas: Pengguna dan pengembang mendapatkan kebebasan untuk memilih dan mengganti penyedia LLM atau vendor alat tanpa harus terikat pada satu platform tertentu.

- Keamanan: MCP dirancang dengan mempertimbangkan keamanan, memungkinkan kontrol akses yang aman ke data lokal dan jarak jauh, sehingga mencegah paparan data yang tidak perlu.

- Efisiensi: Mengurangi waktu dan kompleksitas pengembangan dengan menghilangkan kebutuhan untuk membangun jembatan data custom untuk setiap integrasi baru.

Arsitektur Client-Server MCP

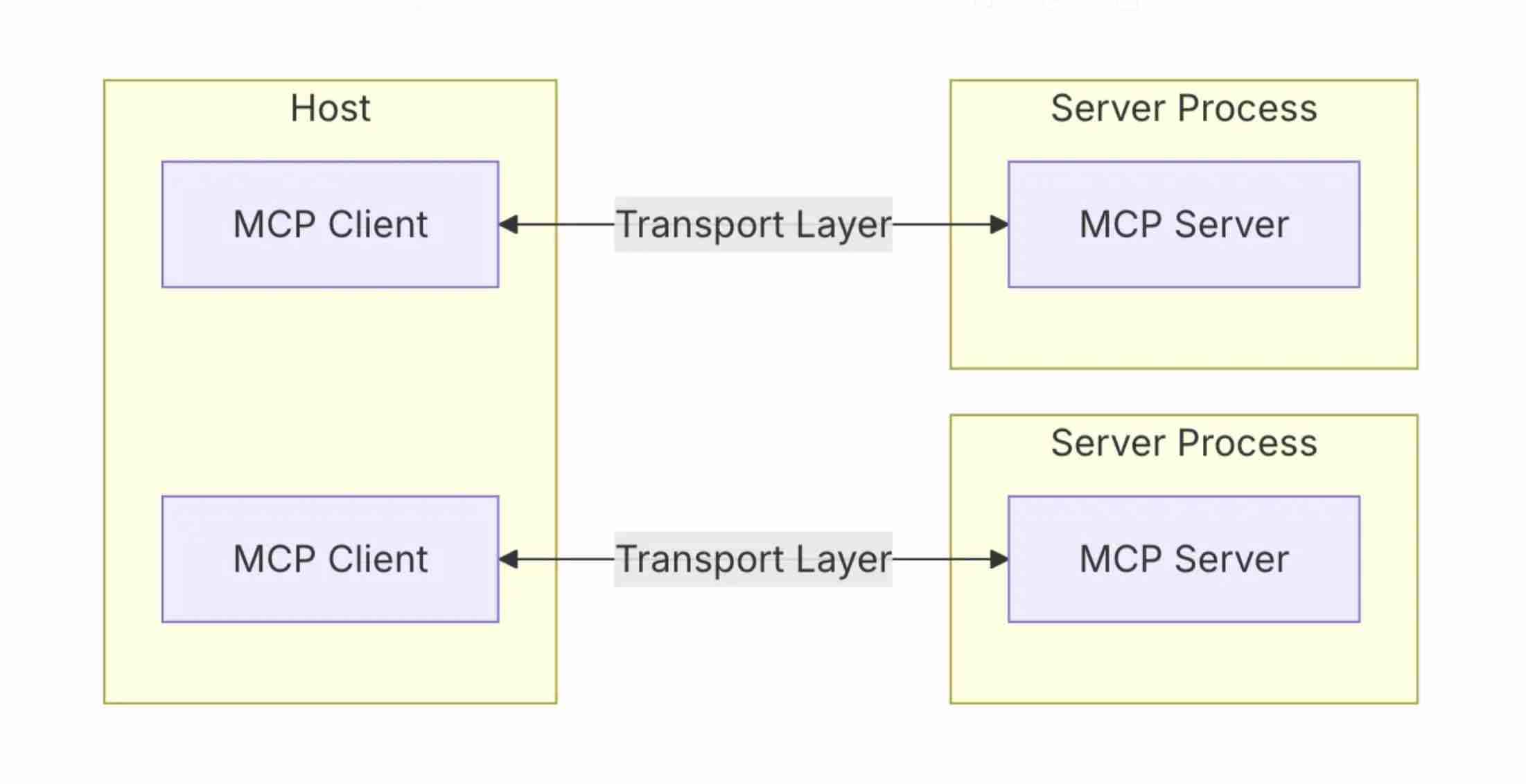

MCP bekerja berdasarkan model arsitektur client-server yang sederhana namun kuat:

- MCP Client: Biasanya merupakan aplikasi yang berinteraksi langsung dengan pengguna atau LLM (contoh: chatbot, IDE, atau agen AI). Klien bertugas mengirimkan permintaan untuk informasi atau eksekusi tugas ke server.

- MCP Server: Adalah program yang menyediakan akses ke sumber daya atau alat tertentu. Server "membungkus" data atau fungsionalitas (seperti API, database, atau file system) ke dalam format yang sesuai dengan standar MCP, sehingga dapat dipahami oleh klien.

Komunikasi antara klien dan server ini dapat terjadi melalui berbagai protokol transport, seperti STDIO (untuk proses lokal) atau HTTP/SSE (untuk layanan jaringan), yang memastikan fleksibilitas dalam berbagai skenario penerapan.

Alur kerjanya secara umum adalah sebagai berikut:

- Permintaan Pengguna: Pengguna memberikan perintah atau pertanyaan kepada aplikasi klien.

- Klien ke LLM: Klien meneruskan permintaan tersebut, bersama dengan informasi tentang alat yang tersedia dari server MCP, ke LLM.

- LLM Memberi Instruksi: LLM menganalisis permintaan dan menentukan alat mana yang perlu digunakan dari server MCP, beserta parameter yang dibutuhkan.

- Klien ke Server: Klien mengirimkan instruksi dari LLM ke server MCP yang sesuai.

- Eksekusi oleh Server: Server menjalankan tugas yang diminta (misalnya, mengambil data cuaca atau mencari dokumen).

- Server ke Klien: Hasil eksekusi dikembalikan ke klien.

- Klien ke LLM untuk Respon Final: Klien mengirimkan hasil dari server ke LLM untuk diproses menjadi jawaban akhir yang natural bagi pengguna.